根据 OpenAI 的说法,就在上周五,他们暂停了字节的账号,具体发生了啥,现在也还在进一步调查中。

世超也去查了查,发现事情,是由外媒 The Verge 的一则报道引起的。

据报道,字节跳动正在悄咪咪地用 OpenAI 的 API ,做一些 “ 不太光彩 ” 的事儿。

和大伙们用 AI 水周报,糊弄领导不一样,按照 The Verge 的说法,字节直接在用 OpenAI 训练自家的大模型。

一般遇到类似传言,世超不会太在意,毕竟套壳大模型、用别家大模型训练自家大模型等等,相关的消息隔三岔五就会来那么一次。

而且都是一些风言风语,没啥实锤,也没啥后续。

但这次不一样了,报道里的内部消息,至少看起来都贼真。

他们说是弄到了字节内部泄露的一份文件。

里面主要讲了字节的大模型项目—— “ 种子计划 ” 的开发过程,几乎在每个阶段,包括训练还有评估,字节的大模型都用了 OpenAI 的 API 。

另外,像是怎么 “ 通过数据脱敏,不被人抓到小尾巴 ” 这类的内部飞书聊天记录,也都给曝出了。

再加上 OpenAI 的直接封号,还真有点坐实了报道里内容的味道。

反正一时间,网友们都纷纷出来吃瓜,各种阴阳国产大模型的言论都出来了——

“ 怪不得国产大模型们一个个都开发得这么快,原来是在偷师 GPT 啊? ” “ 国内的大模型都一股 GPT 味儿,原来问题出在这儿。 ”

国内媒体们都一股脑儿地转载报道,话题还一度飙上了知乎热榜。

而大伙们也应该发现了,争议的中心在于,字节可能调用 OpenAI API 给自家大模型生成训练数据。

说实话,相较与简单粗暴,甚至有些无底线的套壳,这手段,其实文明了不少了。。。

在大模型领域里,我们一般叫它大模型的知识蒸馏。

从名字来看,估计各位差友也能猜出来个一二三,就是用已经训练得差不多的先进大模型,生成一些优质语料,然后再把生成的这些语料喂给更小模型。

说好听点,大模型的知识蒸馏,是帮大家省了前期标注数据、提取优质语料库的功夫,说难听点,这就是在吃别人已经嚼烂的食物,好偷懒省力。

看到这儿,肯定有人会说了,大模型做出来,不就是让人用的么,用户爱咋用咋用,这波字节没做错啥啊?

话是这么说,但是 OpenAI 早就料到了这一手,为了防止自己的数据被薅、被蒸馏, OpenAI 在自家的服务协议早就埋伏上了。

不只有企业,包括个人开发者在内, OpenAI 都禁止他们用 OpenAI 的大模型,去开发竞品。

在普通用户那儿, OpenAI 也没放过。

它给 ChatGPT 和 DALL·E 都套上了枷锁,同样也不让用输出的内容,训练与 OpenAI 竞争的模型。

只要你违反上面那些规定了,按照官方的说法,就只是提前知会一声,随时终止服务。

这些条例就跟唐僧念符之下的紧箍咒一样,越来越紧。。。咱明眼人也都能看出 OpenAI 在自家 “ 数据安全 ” 这块是下狠招了。

虽说字节用的 API 不是从 OpenAI 这边直接买的,而是买的微软 Azure 上的云服务 Azure OpenAI 。

但从微软那边买,同样也是受这个协议约束。

或许是因为这些原因,才有了开头先封号处理,再进一步调查字节的局面。

看着这一盆盆 “ 脏水 ” 泼过来,字节也没干坐着,在周末加班一一给出了回应。

首先,他们称在开发大模型的时候,只是在初期探索阶段用了 GPT 的 API 服务,并且探索阶段的模型还只是测试,没有上线对外使用。

并且根据字节的说法,今年四月份他们内部就明确规定,不能用 GPT 生成的数据训练自己的大模型。

更重要的是,他们说九月份内部还搞了个检查,主要的任务就是看他们的训练数据和 GPT 的相似程度。

未来几天里,他们还准备再来一次全面检查,以确保严格遵守相关服务的使用条款。

到现在为止,反正各方的回应是一箩筐,至于字节到底有没有违反 OpenAI 的服务协议,从现在的信息来看我们也做不出啥判断,只能等后续双方沟通的结果。

不过,在训练大语言模型这块,数据来源的争议其实一直都蛮大。

OpenAI 训练大模型的时候,也曾在数据上栽了不少跟头。

就比如 ChatGPT ,它主要就是爬取一些社交媒体网站、或者论坛、贴吧上的数据。

刚开始,这些数据他们都是免费爬的,但后来 OpenAI 的 ChatGPT 还有 DALL·E 慢慢出圈,一些问题就连带着浮出水面了。

这两个大模型爆火的那段时间, OpenAI 吃的官司是一个接一个。

文生图大模型被各种图片网站、艺术家们起诉,大语言模型被社交平台上的博主索赔。。。

与此同时,各大平台也都开始注重数据价值,像是美版贴吧 Reddit ,还有程序员问答网站 StackOverflow 等等这种优质语料多的网站,都开始设置付费门槛,交钱才能爬取数据。

但在此时 OpenAI 的大模型已经发育起来了,过去网络上的数据该爬的也都爬了。

这下就苦了那些后来者,前期还不仅要做一些标注语料库的重复劳动,还得付费再爬一遍数据。

不过世超觉得,这次真如 The Verge 报道中说的,那这个 “ 锅 ” 铁定还是要字节来背,毕竟相关的条例,早就写在协议里了,拿人家的手短,人家还真有理。

最后,世超想说的是,自从大模型流行以来,业内类似的争议也好、丑闻也好,其实基本就没断过。

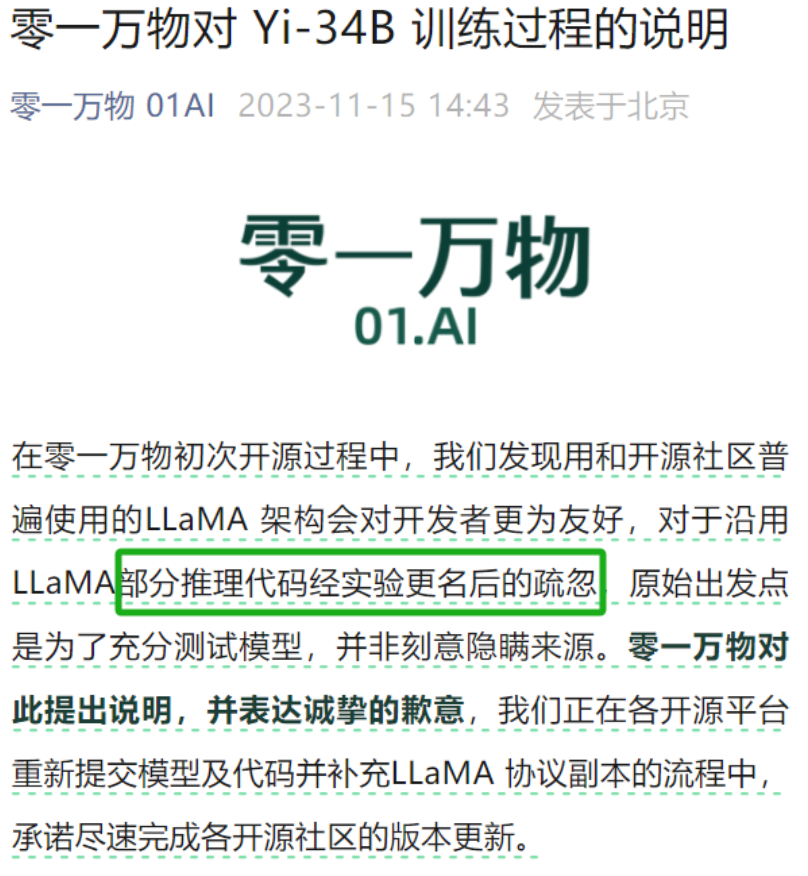

就比如前不久,李开复的大模型 Yi 被扒出是 “ 套壳 ” Meta 的 LLaMA ,虽说后者也是开源的,但要用也得注明。

但李开复还是在网上舆论发酵之后,才不痛不痒地回应了句命名疏忽。。。

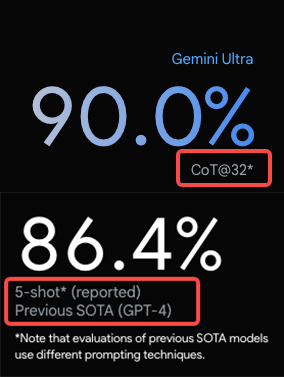

更离谱的是,大模型内部还和机圈儿一样,流行起了跑分热。

有的企业为了让自己的模型分数更好看一点,直接搞起了小动作。

前段时间谷歌的 Gemini ,为了让自家模型的分数比 GPT-4 好看,在测试方法上就动了些手脚。

国内某团队也曾发布过技术报告,里面明晃晃地指出了大模型刷榜的乱象。

他们直接把测评的题目,先喂给了自家大模型。

相当于是开卷刷榜,让自家的大模型在一群 “ 做题家 ” 中脱颖而出。

当然,新兴领域一开始都是乱象丛生,有这些丑闻也不是啥新鲜事儿。

世超也希望,未来,大模型厂商们能主打一个诚实,别今天暴打 GPT-4 ,明天又暴打 OpenAI 的了。

还有用了谁谁谁的数据,用了哪些开源资源,也大大方方承认,作为一个追赶者、学习者,其实没啥丢脸的。。

再回到字节和 OpenAI 这档子事儿,要是真相水落石出,字节确实是被冤枉,世超也希望 OpenAI 和媒体们能立马化身墙头草,还字节一个清白。

少一些套路,多一些真诚,大模型可以有幻觉,人嘛,还是实诚点好。

撰文:松鼠 编辑:江江 封面:焕妍

相关:

河南官方披露仰韶文化早中晚期考古新成果 中新社郑州12月13日电 (记者 韩章云)河南官方13日披露,该省仰韶文化早中晚期考古研究取得新成果。 河南是中华文明的重要发祥地,是中国现代考古学的诞生地,是探索中华文明起源的关键区域。河南省文物..

30卷《李学勤文集》问世 再现生前60余年学术历程 中新网北京12月13日电 (记者 应妮)由江西教育出版社主办的“《李学勤文集》编纂出版座谈会”日前在京举行。该文集共30卷,集中展现了李学勤这位“百科全书式的学者”60余年的学术历程。 《李学勤文集》编..